对于不少游戏玩家来说,RTX 4060Ti不是一个好选择。然而笔者我买了RTX 4060Ti 16G版本,插在显卡坞里面连笔记本电脑。RTX 4060Ti 16G版本我入手价格为3569,而显卡扩展坞内含400W电源,价格为1109元。

在发烧友看来,这简直是buff叠满了,又是4060ti,还买了16G显存版本(16G大显存版本寻址时间更长,游戏性能反而下降),又用显卡坞这种性能折损的东西。

但问题是,我的需求是在本地跑大语言模型。

- RTX 4060 Ti是目前最便宜的能提供16G显存的消费级显卡,别跟我说什么矿卡,我不可能买这种稳定性堪忧的东西;

- 不买4070因为4070是12G显存,chatGLM需要12.6GB显存,LLaMA需要13.5GB显存,我想跑非量化的完整模型16G显存是正好;

- 模型首先能要跑得起来,比跑的快不快重要得多。不买4080/4090是因为我不会为了一个体验性质的AI花上万,用显卡坞我不需要配主机,直接在笔记本电脑连接。

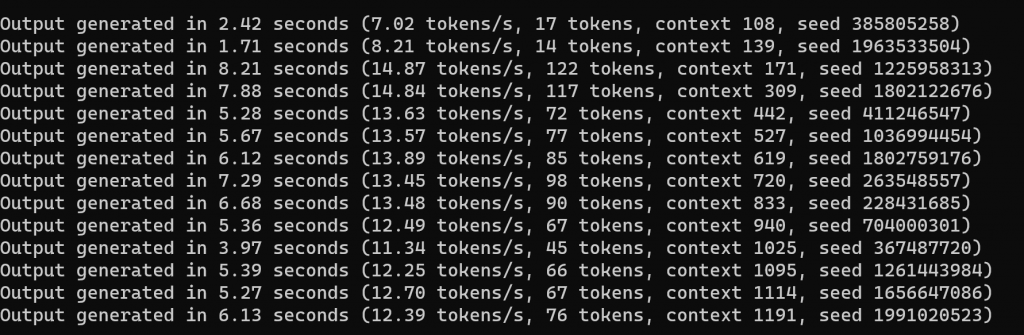

- 何况RTX 4060 Ti能做到一秒钟13-14token的生成速度,在我看来已经很快了。

- 雷电扩展坞的问题,大语言模型跑在显存里面,雷电带宽不影响性能。

- RTX 4060 Ti非常省电,在实际跑的时候,只有80W多的功耗,显卡坞自带的400W电源完全足够了;

RTX 4060 Ti对于本地大语言模型运行推理,是一个低功耗、价格最低的选择。如果说游戏性能,我不关心,因为我不打游戏。

![]()

显卡坞什么型号呢,可以推荐下吗

淘宝上一家叫做“金捷海量”的店购买的,带400W电源,价格大概1100,显卡坞理论上能放下3风扇的卡。

兩張4060 ti 16g 效果會好點嗎?

主要是,40系显卡没有NV Link了啊,两张卡之间的数据交互怎么解决呢。

你用笔记本外接16G显卡跑大模型, 对笔记本的内存有要求吗?

跑大语言模型的过程是先加载到内存,然后加载到显存。所以对于内存大小会有要求的。

你的笔记本内存是多大

32G的。32G对于加载chatglm2-6B、llama2-7B是足够的。

请问有和笔记本搭载的独显做过并行运算吗

没有。

用M.2外接的还是雷电3啊?

雷电接口的。不是M2。