2024年已经到了4月,笔者斗胆在此时对未来做一个展望,接下来我们会看到AI行业诸多悖论和矛盾现象的出现,请不要觉得奇怪。AI渗透率和付费意愿不断提高,和GPU需求增长放缓将会是同时发生的。

1. AI渗透率和付费意愿不断提高,OpenAI这类MaaS的模型公司收入继续增长。

你一定看到过新闻,例如chatGPT的访问量已经见顶,甚至有所下滑。有些人据此推算,这一轮以聊天机器人作为代表的AI,可能渗透率已经见顶。

然而,事实是尝鲜用户逐步流失,但是真正有生产力需求的用户逐步沉淀下来,付费意愿提升。

2022和2023年,很多用户仍然出于好奇和尝鲜,提问几个问题之后就不再使用了。但真正需要文档总结、代码编写和调试的用户,则会留存。

在付费意愿方面,2023年,个人用户开会员体验一下GPT 4居多,那么到了2024年企业用户渗透率将大幅度提升。团队版和企业版chatGPT数据将不会被用于模型训练。企业将会出于提升员工生产力、保护企业机密数据的要求,采购团队版和企业版chatGPT。chatGPT类的AI助手,将真正融入到企业用户生产流当中。

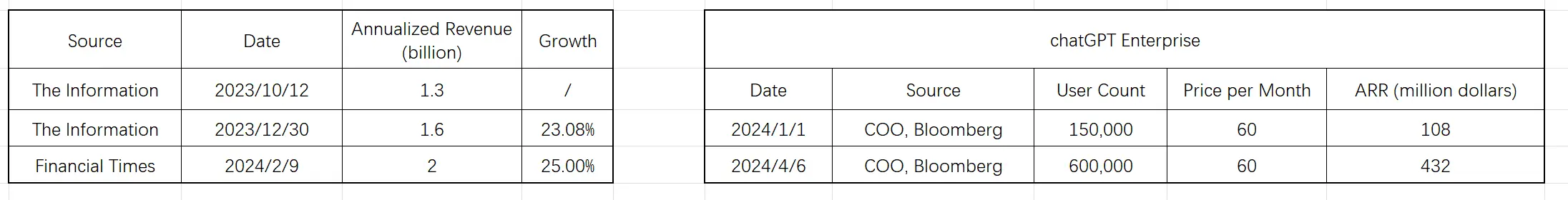

OpenAI的CTO在4月接受彭博社采访当中就透露,仅仅2024年1月到4月,企业付费用户就从15万增长到了60万。仅此一项,以企业版60美元每月估计,年化营收ARR就达到了4.3亿美元。

尽管唱衰声音不断,OpenAI的年度经常性收入从13、16亿美元增长到20亿美元,增长有望持续。

2. GPU需求明显放缓。

2023年AI数据中心和集群从无到有建立,云计算厂商会一次性采购数以10万的A100 / H100。到了2024年,随着数据中心建立完成,云厂商会进入常规的维护和升级状态,采购量将会大幅度下降。从原来的一次性10万,到2-3万H100 / B100。

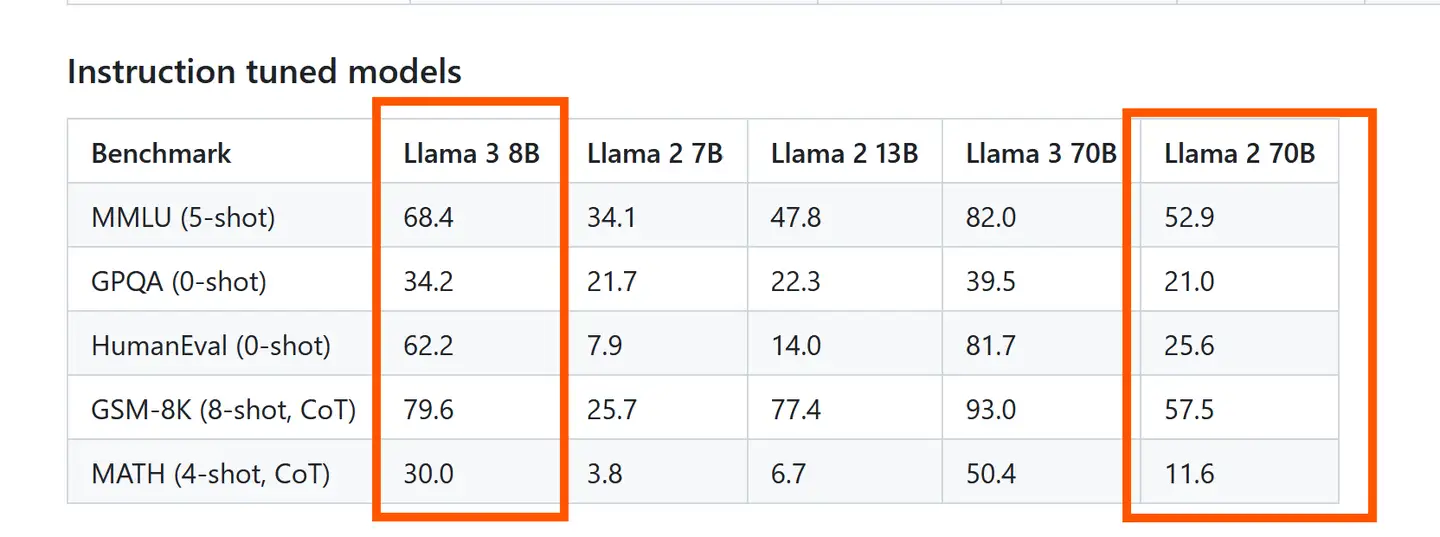

其次是新一代模型做到了模型更小、能力更优,开源模型LLaMa 3的8B版本能力全方位超越了LLaMa 2的70B版本。

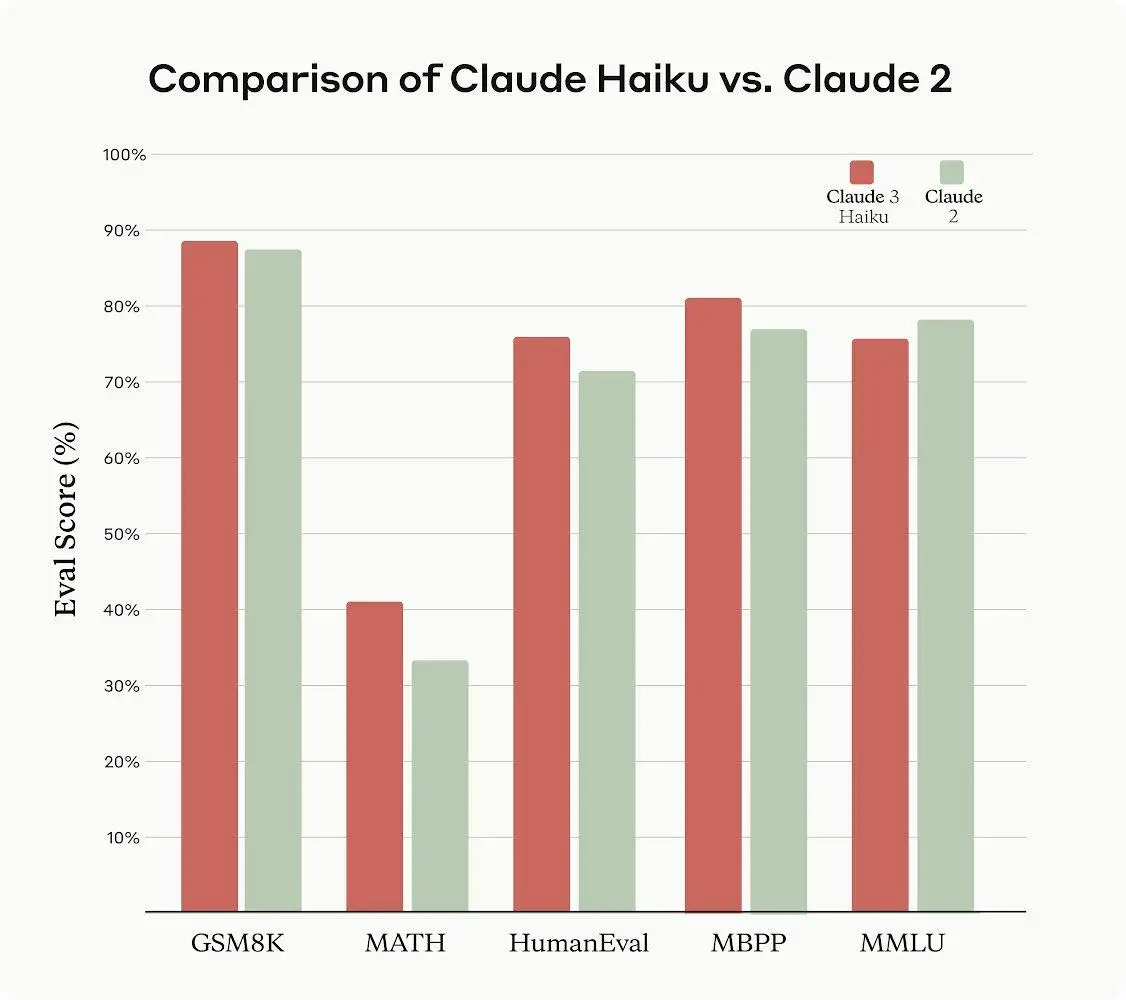

闭源模型当中,anthropic旗下的Claude 3的小杯Haiku版本,能力基本持平上一代Claude 2,但API调用的价格却只有前代的1/20,大幅度降低。

中小模型远远没有收敛。在给定的模型体积下,通过更多的数据、更科学的数据清理方式,模型能力未来提升空间很大。

尽管舆论和市场共识追捧乃至神化GPU,但GPU需求将会受到数据中心集群建设周期、模型更小更优的双重打击,增长放缓是确定性事件。

![]()